Was ist ein optisches Wellenlängen-Messgerät?

Ein optisches Wellenlängen-Messgerät ist ein spezielles Gerät zur Messung der Wellenlänge von Licht.

Da es die Wellenlänge des Lichts misst, ist es fast gleichbedeutend mit einem optischen Spektrumanalysator, aber optische Wellenlängen-Messgeräte haben im Allgemeinen einen engeren Messdynamikbereich und sind daher empfindlicher.

Optische Spektrumanalysatoren verfügen über eine Vielzahl von Funktionen, die sie vielseitig einsetzbar machen, während optische Wellenlängen-Messgeräte auf die Minimalfunktion der Wellenlängenmessung beschränkt und daher preisgünstiger sind.

Die mit optischen Wellenlängen-Messgeräten erzielten Ergebnisse entsprechen der Wellenlänge des Lichts im Vakuum und weichen von der tatsächlich in Luft beobachteten Wellenlänge um den Betrag des Brechungsindex der Luft (etwa 0,03 %) ab.

Anwendungen von optischen Wellenlängen-Messgeräten

Optische Wellenlängen-Messgeräte werden häufig eingesetzt, wenn eine höhere Wellenlängengenauigkeit bei der Charakterisierung von optischen Komponenten erforderlich ist.

Sie werden beispielsweise zur genauen Messung der Wellenlängeneigenschaften von Lichtquellen mit geringer Bandbreite, wie Lasern und LEDs, oder zur Bewertung der Wellenlängeneigenschaften von Licht in der Glasfaserkommunikation verwendet.

Viele optische Wellenlängen-Messgeräte haben einen Messbereich zwischen 1000 und 1800 nm, da sie ursprünglich häufig zur Messung der Wellenlänge von Licht in der faseroptischen Kommunikation verwendet wurden.

Funktionsweise von optischen Wellenlängen-Messgeräten

Die Funktionsweise der optischen Wellenlängen-Messgeräte besteht darin, dass sie die physikalische Interferenz von Licht nutzen, wie z. B. Fizeau-Interferometer und Michelson-Interferometer, um die Wellenlängeneigenschaften von Licht zu messen.

Das Fizeau-Interferometer ist ein sehr einfaches optisches System, das aus einer Kollimatorlinse, einer als Bezugsebene bezeichneten Glasplatte und einem Messspiegel besteht.

Das auf das Fizeau-Interferometer einfallende Licht wird durch die Kollimatorlinse kollimiert und dann beim Durchgang durch die Referenzebene teilweise reflektiert. Das Licht, das die Referenzebene durchläuft, wird vom Messspiegel reflektiert und interferiert mit dem an der Referenzebene reflektierten Licht, wodurch ein streifenförmiges Muster entsteht. Diese Interferenzstreifen sind von der Wellenlänge des Lichts und dem optischen Wegunterschied des interferierenden Lichts abhängig.

Da der Abstand zwischen der Bezugsebene und dem Messspiegel (optischer Gangunterschied) bekannt ist, kann die Wellenlänge aus dem Interferenzstreifenmuster berechnet werden. Bei der Michelson-Interferometrie wird das einfallende Licht durch einen Strahlteiler in zwei Strahlen aufgeteilt und die Intensitätsänderungen des Interferenzlichts werden gemessen, indem der optische Gangunterschied auf verschiedene Weise verändert wird. Durch inverse Fourier-Transformation kann das Spektrum (die Wellenlänge) des Lichts berechnet werden.

Weitere Informationen zu optischen Wellenlängen-Messgeräte

1. Optische Wellenlängen-Messgeräte und faseroptische Kommunikation

Optische Wellenlängen-Messgeräte werden häufig für optische Messungen in der Glasfaserkommunikation eingesetzt. Der Wellenlängenbereich von 1500 nm ist der am häufigsten verwendete Wellenlängenbereich für Glasfasern, da er den geringsten Lichtverlust bei der Übertragung in Glasfasern aufweist.

In den letzten Jahren sind die Glasfaserkommunikationsnetze jedoch bereits mit diesem Wellenlängenband allein gesättigt, so dass auch die Nutzung der umliegenden optischen Wellenlängenbänder aktiv entwickelt und umgesetzt wird.

Wellenlängen-Multiplexing ist eine der wesentlichen Technologien zur Erhöhung der Kapazität von Glasfaserkommunikationsnetzen und optische Wellenlängen-Messgeräte müssen in der Lage sein, mehrere Wellenlängen gleichzeitig zu messen und dabei eine praxisgerechte Auflösung zu erreichen. Vor diesem Hintergrund bieten einige Hersteller heute Modelle an, die mehrere Wellenlängen gleichzeitig messen können, bis zu einem Maximum von 1024 Wellenlängen.

2. Andere Anwendungen als Faseroptik-Kommunikation

Halbleiterlaser auf Basis von Verbindungshalbleitersubstraten sind als Lichtquellen für die Glasfaserkommunikation weit verbreitet und es besteht ein Bedarf an Modellen, die eine begrenzte Anzahl einzelner Wellenlängen mit sehr hoher Geschwindigkeit für die Inspektion von Halbleiterwafern und Laserchip-Massenproduktionslinien vor der Waferherstellung auswerten können.

Da die Lichtquelle für faseroptische Verstärker im 900-nm-Band liegt, werden Modelle benötigt, die Messungen bei optischen Wellenlängen von weniger als 1000 nm durchführen können.

Darüber hinaus verwendet die optische Kohärenztomographie, die heutzutage häufig in der ophthalmologischen Diagnose eingesetzt wird, Wellenlängen im Bereich von 800 nm und 1050 nm, während Fluoreszenzbeobachtungsanwendungen in der Biotechnologie hauptsächlich im sichtbaren Licht stattfinden, so dass es auch Modelle gibt, die Wellenlängen im Bereich von 300 nm bis 1200 nm verarbeiten können. Einige Modelle sind für den Einsatz im Bereich von 300 nm bis 1200 nm erhältlich.

3. Modelle, die mit CW- und gepulsten Lichtquellen kompatibel sind

Bei Laseranwendungen gibt es Fälle, in denen CW-Laseroszillation verwendet wird, und Fälle, in denen eine gepulste Hochgeschwindigkeitslichtquelle, z. B. 1 KHz, eingesetzt wird.

Einige hochwertigere Modelle können beides, während einige Wellenlängen-Messgeräte nur für Anwendungen im CW-Betrieb geeignet sind, so dass es wichtig ist, die Spezifikationen sorgfältig zu prüfen.

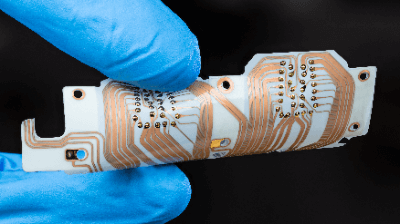

FPCs sind flexible Leiterplatten. Sie zeichnen sich durch ihre Papierdünne und Weichheit aus. Da sie leichter, kleiner und wirtschaftlicher sind als normale Substrate, haben sie in den letzten Jahren weite Verbreitung gefunden.

FPCs sind flexible Leiterplatten. Sie zeichnen sich durch ihre Papierdünne und Weichheit aus. Da sie leichter, kleiner und wirtschaftlicher sind als normale Substrate, haben sie in den letzten Jahren weite Verbreitung gefunden.