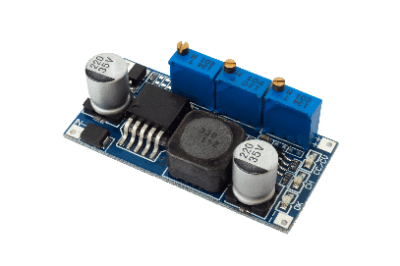

Was ist eine Leiterplatte?

Eine Leiterplatte ist eine gedruckte Schaltung mit mehreren Schichten.

Der Einsatz von Leiterplatten ermöglicht die Verwendung von Leiterplatten mit hoher Dichte auf kleinem Raum, was die Herstellung multifunktionaler Produkte, z. B. in kleinen Geräten, ermöglicht. Leiterplatten bestehen aus übereinander gestapelten Lagen von Leitern und Isolatoren, die mit Laserbohrungen und Verdrahtungsprozessen durchdrungen werden, wodurch komplexe Substrate auf kleinem Raum hergestellt werden können.

Entstehung von Leiterplatten-Substraten

Da die Leiterplatten immer dichter werden, wird es immer schwieriger, mit der derzeitigen Durchgangslochstruktur allein auszukommen. Die Entwicklung von Mobiltelefonen hat Substrate erforderlich gemacht, die leichter und kleiner sind. Leiterplatten kamen um das Jahr 2000 auf den Markt und haben sich bis heute gehalten.

Leiterplatten werden in Europa und den USA als Micro-Vias bezeichnet, während sie in anderen Ländern als HDI (HIGH density interconnection) Micro-via Laser-via bezeichnet werden. In Japan wird hauptsächlich die Bezeichnung “build-up” verwendet. Wie der Name “Leiterplatte” schon sagt, handelt es sich um eine Leiterplatte mit mehreren Schichten.

Normalerweise kann eine mehrlagige Leiterplatte in einem einzigen Stapel aufgebaut werden, aber dieses Verfahren erhöht den Arbeitsaufwand und die Kosten, wird aber zunehmend aus den folgenden zwei Hauptgründen verwendet:

1. Verringerung der Platzverschwendung

Bei der Verwendung von Durchgangslöchern (Löcher zur Verbindung anderer Lagen) für mehrlagige Leiterplatten ist eine Verdrahtung außerhalb der Verbindungslage wegen der Durchgangslöcher nicht möglich. Dies bedeutet, dass die Verdrahtungseffizienz nicht verbessert werden kann, selbst wenn eine mehrlagige Leiterplatte verwendet wird.

2. Kleine Löcher mit Laser bohrbar

Dank der Fortschritte bei den Geräten ist es möglich, mit Lasern kleinere Löcher mit höherer Geschwindigkeit zu bohren als mit Bohrern. Beim Bohren mit einem Bohrer durchdringt das Loch die darunter liegende Schicht, aber mit einem Laser ist es möglich, ein Loch durch das Harz zu bohren und den Prozess auf dem Kupfer zu stoppen, wenn die Bedingungen kombiniert sind.

Daher kann durch den Aufbau (build-up) des Prozesses des Bohrens von Löchern mit einem Laser nach der Mehrfachbeschichtung, der Beschichtung und dem anschließenden Aufbau der nächsten Schicht und deren Bearbeitung mit einem Laser der Durchgangslochbereich effektiv genutzt werden und eine hohe Dichte ist möglich.

Der Einsatz von Leiterplatten ermöglicht die Verwendung von Substraten mit hoher Dichte auf kleiner Fläche, was die Herstellung multifunktionaler Produkte, z. B. in kleinen Geräten, ermöglicht. Es können komplexe Substrate mit kleinen Flächen hergestellt werden.

Anwendungen von Leiterplatten

Leiterplatten werden häufig in kleinen, leichten elektronischen Geräten verwendet. Als Leiterplatten zum ersten Mal in der Praxis verwendet wurden, kamen sie in PCs und Mobiltelefonen zum Einsatz, aber heute werden sie in kleinen Messgeräten, IoT-Geräten wie Smart Metern, digitalen Kameramodulen und PC-Peripheriegeräten verwendet.

Die Genauigkeit des Bohrens und anderer Prozesse bei der Herstellung von Leiterplatten hat Standards gesetzt und es ist notwendig, bei der Beauftragung der Erstellung einer Leiterplatte genau zu wählen, welches Genauigkeitsniveau gewünscht wird.

Verfahren zur Herstellung von Leiterplatten

Der Herstellungsprozess für Leiterplatten umfasst die Bildung der Isolierschicht, die Bearbeitung von Durchkontaktierungen, die Entfernung von Schlieren und die Beschichtung von Durchkontaktierungen:

1. Bildung der Aufbauschicht

Auf die Leiterplatte wird eine Isolierschicht aufgebracht. Bei diesem Verfahren kann Prepreg, ein starres Material oder eine Folie verwendet werden. Prepreg wird häufig für die Verpackung von Halbleitern für Digitalkameras und Smartphones verwendet.

2. Via-Verarbeitung

Hierbei handelt es sich um das Bohren von Löchern, sogenannten Vias, in die Isolierschicht zwischen den Substraten. Derzeit wird zum Bohren von Löchern in der Regel ein Laser verwendet.

Es werden auch verschiedene Lasertypen und Wellenlängen verwendet, z. B. Kohlendioxidgas und UV-YAG. Kohlendioxidgas hat eine lange Infrarot-Wellenlänge und wird daher häufig in Digitalkameras und Smartphones verwendet, während UV-YAG eine kurze Ultraviolett-Wellenlänge hat und in Bereichen mit hoher Dichte wie Halbleiter-Verpackungssubstraten eingesetzt wird.

3. Entfernung von Harzrückständen (Desmear)

Rückstände, die bei der Laserbearbeitung entstehen, werden als ‚Smear‘ bezeichnet. Harzrückstände lassen sich nicht verbinden und müssen entfernt werden. Dieser Vorgang wird als ‚Desmear‘ bezeichnet. Bleibt die Schmiere auf den Leiterplatten, kann sie zu schlechten Verbindungen führen und muss daher unbedingt entfernt werden.

Er muss mit einer starken Chemikalie (Kaliumpermanganat) entfernt werden, aber da die neueren Hochgeschwindigkeitsharze möglicherweise nicht in der Lage sind, ihn zu entfernen, können Plasma oder andere Methoden in Kombination verwendet werden.

4. Beschichtung von Durchkontaktierungen

Die Beschichtung von Durchkontaktierungen wird verwendet, um Schaltungen zwischen Platinen mit dazwischen liegenden Isolatoren zu verbinden. Da die Beschichtung auf kleinen Löchern erfolgt, ist darauf zu achten, dass keine Luftblasen eindringen.

Weitere Informationen zu Leiterplatten

1. Bezeichnungen der Durchkontaktierungen auf Leiterplatten

Die Bezeichnungen variieren je nach Anordnung und Struktur der Löcher und werden daher im Folgenden kurz erläutert:

Gestaffeltes Via

Hierbei handelt es sich um eine Methode, bei der die Position der Durchkontaktierungen wie bei einer Treppe verschoben wird.

Gestapeltes Via

Ein Via wird über ein anderes Via gestapelt. Ein Via, das sich auf allen Lagen überlappt, wird als Full-Stack-Via bezeichnet.

IVH (Englisch: Interstitial VIA Hole) interne Durchgangsbohrung

In der nicht gebauten Schicht müssen Löcher gebohrt werden, um die obere und untere Schicht zu verbinden. Diese Bezeichnung wird verwendet, weil sich die Löcher strukturell im Inneren der Leiterplatte befinden. Sie wird auch als Blind Via bezeichnet. Es ist üblich, die Aufbaulagen und die IVH-Lagen getrennt zu beschreiben.

2. Unterschied zwischen einer Leiterplatte und einer Any-Layer-Platte

Bei einer Leiterplatte werden die zu verdrahtenden Lagen auf beiden Seiten der Kernlage gestapelt, aber wenn alle Lagen Aufbaulagen sind, spricht man von einer Any-Layer-Platte.

In der bisherigen Schreibweise wäre dies 3-0-3 (6-Lagen Any Layer), aber da es nicht gut passt, 0 für unbenutzte Lagen zu verwenden, wird der Begriff als die Anzahl der Lagen + Any Layer verwendet.

Any-Layer-Platinen benötigen keine Kernschicht zur Bildung von Durchgangslöchern. Bei einer Leiterplatte ist die IVH-Stelle die Leitung der konventionellen Platte, während die Any-Layer-Platte frei zwischen den Lagen verbunden werden kann, indem nur Durchgangslöcher mit kleinem Durchmesser mit einem Laser gebohrt werden.

Aufgrund dieser unterschiedlichen Eigenschaften können Any Layer-Substrate dichter sein als herkömmliche Leiterplatten, was zu leichteren, dünneren und kleineren Produkten führt. Obwohl die Anzahl der Prozesse und die Kosten höher sind, werden sie aus den oben genannten Gründen häufig in Smartphones und anderen Produkten verwendet.

3. Materialien für Leiterplatten

Derzeit werden hauptsächlich zwei Arten von Materialien verwendet: Glasgewebe, das dem normalen Substratmaterial entspricht und Folie, die hauptsächlich für Verpackungen verwendet wird. In der Vergangenheit wurden viele verschiedene Materialien verwendet.

Die Entwicklung von Leiterplatten begann, als IBM die Technologie für die Montage großer Computer-Flip-Chips für seine eigene Produktpalette entwickelte. In diesem Zusammenhang wurden verschiedene Studien durchgeführt.

Als Ergebnis wurde eine Belichtungs- und Entwicklungsmethode mit UV-härtendem Harz, dem so genannten Photovia, eingeführt. Dies hatte den Vorteil, dass die Durchkontaktierungen in einer Charge hergestellt werden konnten. Da eine Zwischenschichtdicke erforderlich war, wurde die Entwicklung auf der Grundlage von Materialien für Lötstopplacke für Vorhangbeschichter durchgeführt, die eine Schichtdicke erzielen können und es wurde eine Massenproduktion erreicht. Wie beim Lötstopplack wurde eine Isolierschicht durch Auftragen, Belichten und Entwickeln gebildet, gefolgt von einer abschließenden Aushärtung durch Wärme.

Danach wird chemisches Kupfer abgeschieden und eine elektrolytische Verkupferung durchgeführt, um Schicht für Schicht zu bilden. Bei der Bildung von chemischem Kupfer ist es aufgrund der Photopolymerisation des Harzes schwierig, die Schälfestigkeit zu erreichen, was die Kontrolle der Bedingungen extrem erschwert. Darüber hinaus erforderte der Entwicklungsprozess ein Lösungsmittel und unterlag verschiedenen Vorschriften, so dass man nicht von einer weit verbreiteten Technologie sprechen kann.

Später wurde das Verfahren zur Herstellung von Microvias von der optischen Herstellung auf die Laserbearbeitung umgestellt, da sich die Verarbeitungsgeschwindigkeit von Vias aufgrund der erheblichen Weiterentwicklung der Laserbearbeitungsgeräte um das Dutzendfache erhöhte. Zu dieser Zeit wurde RCC (Resin Coated Copper Foil) eingeführt. Dabei handelt es sich um ein wärmehärtendes Harz, das auf die Kupferfolie aufgetragen wird und sich in demselben halb ausgehärteten Zustand befindet wie Prepreg.

Dies hat den Vorteil, dass das Laminierungsverfahren, das dasselbe Verfahren wie bei herkömmlichen Substraten ist, verwendet werden kann. Da außerdem die Schälfestigkeit leichter zu erreichen ist, wurde die Via-Bildung mit Licht durch die Laser-Bildung von RCCs ersetzt.

Da elektronische Geräte immer kleiner und handlicher geworden sind, hat sich der Einsatz von Leiterplatten ausgeweitet. In diesem Zusammenhang sind weitere Kostensenkungen und eine Zuverlässigkeit, die hohe Dichten bewältigen kann, erforderlich.

Darüber hinaus haben erhebliche Verbesserungen in der Laserbearbeitungstechnologie es ermöglicht, gängige Materialien mit Glasgewebe zu bearbeiten, was zu einem erheblichen Anstieg der Verwendung von Materialien mit Glasgewebe geführt hat. Verschiedene Handys, wie Mobiltelefone und Digitalkameras, sind von dieser Art.

Bei der LSI-Verpackung hingegen ist ein mehrstufiger Aufbau mit hoher Dichte erforderlich, um dem hochdichten Flip-Chip von LSIs gerecht zu werden. Um mehrere Schichten und ein niedriges Profil unterzubringen, sind dünnere Zwischenschichtdicken, kleinere Vias und flache Oberflächen erforderlich. Um diese Anforderungen zu erfüllen, wurden folienartige Materialien entwickelt.

Um den Schaltkreis mit Harz zu füllen, ist ein Vakuumlaminator und für die Abscheidung des chemischen Kupfers auf der Harzoberfläche ist eine spezielle Anlage erforderlich. Dies erfordert hohe Investitionen. In Verpackungsanwendungen wird es für große MPU-LSI in PC-Smartphones verwendet.

Monolithische Keramikkondensatoren, auch bekannt als MLCC (Multi-Layer Ceramic Capacitors), sind Kondensatoren in Chip-Bauweise mit mehreren Schichten von Innenelektroden und dielektrischen Schichten. In der Kondensatorindustrie wird eine weitere Entwicklung erwartet, bei der die Miniaturisierung und die Kapazität zunehmen.

Monolithische Keramikkondensatoren, auch bekannt als MLCC (Multi-Layer Ceramic Capacitors), sind Kondensatoren in Chip-Bauweise mit mehreren Schichten von Innenelektroden und dielektrischen Schichten. In der Kondensatorindustrie wird eine weitere Entwicklung erwartet, bei der die Miniaturisierung und die Kapazität zunehmen.

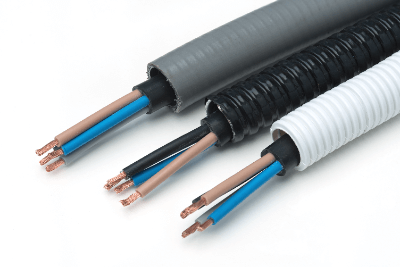

Kabelschutzvorrichtungen sind Produkte, die dazu dienen, verschiedene Arten von Kabeln vor Kräften und elektrischen Einwirkungen zu schützen.

Kabelschutzvorrichtungen sind Produkte, die dazu dienen, verschiedene Arten von Kabeln vor Kräften und elektrischen Einwirkungen zu schützen.